È vero o è falso dire che in fin dei conti il ragionare dell’uomo gira sempre intorno alle proprie paure di perdere qualcosa? Che sia perdere qualcosa che già ha, oppure una opportunità di ottenere qualcosa che ancora non ha. Quasi tutti ricordiamo certi film dell’orrore con bambole dagli occhi spalancati che si muovono, oppure zombie che camminano.

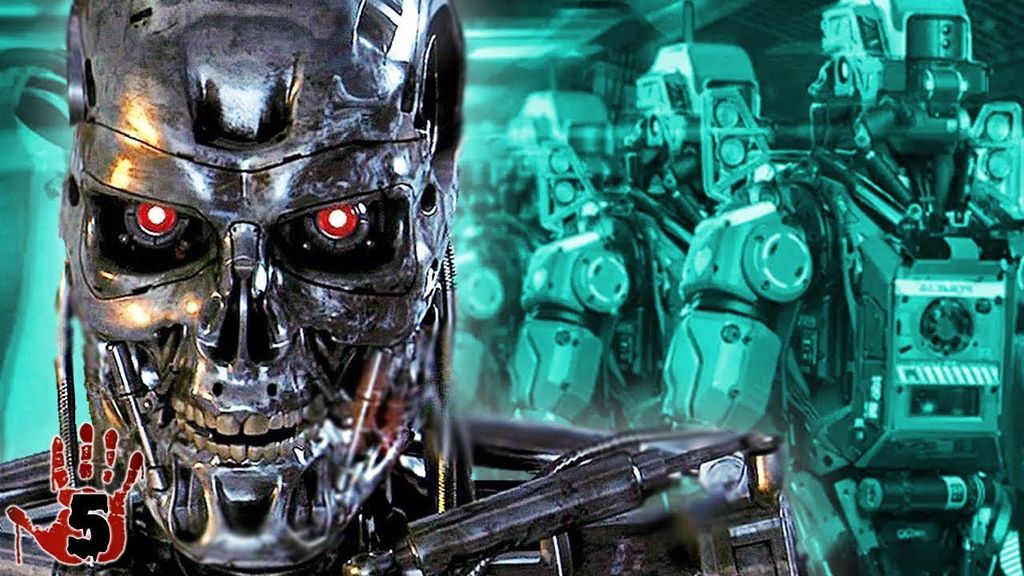

Nel caso di questi film la paura dello spettatore, immedesimandosi, è quella di perdere la vita per mezzo di qualcosa che “non ragiona come un uomo”, e quindi capace di ogni cosa. Umanoidi che pur agendo “intelligentemente” come un uomo, quindi capaci di inseguire altre persone con un coltellaccio, oppure aprire porte o pianificare un atti orribili, ci immobilizzano molto più di quanto non possa fare un umano violento, ciò perché su di essi non abbiamo potere comunicativo.

Abbiamo parlato molto di filosofia, essenza ed esistenza in relazione all’AI negli ultimi articoli; abbiamo spesso alluso che questo argomentare giri intorno ad una paura di base riconducibile a quella che amiamo definire la “paura ontologica“, ovvero la paura di essere, in fondo, anche noi solo materia.

Oggi vogliamo accennare ad un’altra paura che invece è molto diversa e che, alla luce anche di quanto discusso nell’ultimo articolo ove parlavamo di Gombrovicz, è più annoverabile come una paura esistenziale, diciamo pure “umana” (ma perché, le paure possono essere non umane?). Oggi parliamo del perché una bambola che cammina, uno zombie oppure un robot con AI possono indurre un profondo senso di inquietudine, che gli scienziati hanno chiamato Uncanny Valley (valle di misteriosa inquietudine).

Tal termine fu coniato dal giapponese Masahiro Mori nel 1970, la valle si riferisce ad una curva che mostra un crollo di empatia, e quindi ad una seguente angoscia, ma mano che un artefatto assomigli sempre di più ad un uomo, senza di fatto esserlo. Questa valle emotiva è stata parecchio studiata negli ultimi 50 anni, soprattutto nel mondo dei videogiochi, sempre interessati a generare emozioni forti nello svolgimento della strategia di gioco. Mori sostanzialmente dice che la nostra simpatia verso una tecnologia che appare sempre più simile all’uomo va aumentando, ma ad un certo punto, quando la somiglianza è eccessiva, genera una profonda inquietudine, crollando quindi drasticamente. La paura dei clown è legata a questo fenomeno, le stesse agenzie pubblicitarie ne devono tenere conto, interessante un articolo del Daily Mail Reporter del 2011 dove si spiega per quale motivo la catena Burger King ritira dai negozi l’inquietante mascotte a dimensione uomo.

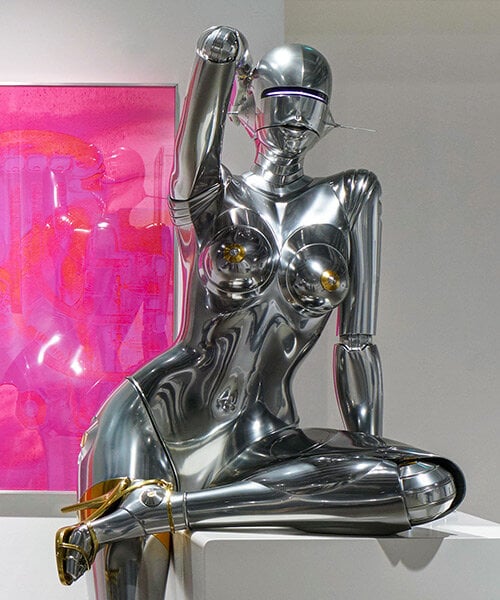

Nella parte più bassa della valle vi è una vera e propria repulsione verso il manufatto, per poi eventualmente risalire oltre una soglia in cui il manufatto riesce in effetti ad entrare in empatia con l’uomo, al punto da confondersi con esso. A tal proposito, in un provocatorio articolo su questo magazine (76 domande cui non vorresti dover pensare. Tra cui fare l’amore con un robot), abbiamo precedentemente elencato domande sparse su come l’uomo debba interpretare una eventuale empatia artificiale.

Ma da cosa nasce l’effetto uncanny valley? Ci sono stati vari studi. In uno studio del 2009 (“Troppo vero per essere confortevole“) si ipotizza che nel nostro DNA siano presenti comportamenti emotivi di disgusto verso ciò che ci assomiglia ma che è imperfetto, visto come portatore di malattie trasmissibili. Il disgusto rientra come una possibilità in una prima area di possibili cause. Altri ricercatori hanno invece rilevato che un umanoide non perfetto ci collega all’idea di cadavere e quindi di morte, provocando ancora una volta disgusto ed inquietudine. Una terza linea di pensiero, che riteniamo molto interessate invero, ipotizza che la uncanny valley non sia un disgusto per qualcosa che esiste, ma piuttosto per qualcosa che manca. Il ricercatore David Hanson, nel 2005, attribuisce la uncanny valley al fatto che gli umanoidi non apparirebbero abbastanza in salute, feritili e attraenti.

Hanson quindi sposta l’attenzione su ciò che intimamente desideriamo, ancora una volta rimandiamo alle provocatorie 76 domande del precedente articolo: sarà mai possibile avere attrazione sessuale per un robot? Hanson nel suo paper (Exploring the Aesthetic Range for Humanoid Robots) è critico sulla valle definita da Mori e sposta l’attenzione a cosa veramente sia il “realismo umano”.

L’uncanney valley è nata in seno ad un contesto principalmente visuale, per poi spostarsi ad analizzare il movimento, mentre ora la domanda è se questo effetto abbia una rilevanza anche nei confronti dell’Intelligenza Artificiale. Attingendo a contributi nell’ambito del marketing possiamo certamente dire che una simile reazione vi è in relazione ai ChatBot con cui spesso interagiamo quando ci imbattiamo in centralini automatici, siti o sistemi di CRM (Customer Relationship Management) in generale. In una prima versione primordiale (“pigia 1. per le vendite e 2. per l’assistenza”) possiamo trovarli utili, in una fase più avanzata ma non adeguatamente avanzata (“esprimi la tua esigenza parlando”, “non ho capito ripeti”) provocano irritazione e disagio, per poi, in una fase estremamente avanzata, al punto da interagire con il cliente senza alcun disagio, portano ad una soddisfazione totale, infatti i consumatori di norma vorrebbero avere piena e veloce riposta alle loro questioni, ma senza possibilmente interagire con una persona reale, ciò per vari motivi tra cui non dover dare troppe spiegazioni (in caso di un reso ad esempio), oppure non voler essere ammorbati per comprare altro o ancora non dover vivere la frustrante esperienza di:”la passo a un altro reparto”. Anche qui abbiamo una valle, la tecnologia deve essere minima o totalizzante, in una fase di solo apparente perfezione provoca disagio.

Oggi sempre più siamo abituati ad avere prime diagnosi su problemi di salute generate da sistemi di AI o ricerca automatica. Anche in questo caso è ritenuto accettabile un approccio basico, diciamo tipico di Google, dove si ha una sequenza abbastanza ampia di possibilità diagnostiche, o, al lato opposto, un sistema estremamente competente sul problema, ciò che non sarebbe accettabile è un sistema che appaia autorevole, ma fallace e non affidabile in una anche piccola percentuale di diagnosi.

L’uomo è abituato a interagire con l’uomo, quando ottiene risposte errate, inquietanti o non comprensibili da altri uomini tende a generare una giustificazione, vi è sempre una sottile linea di empatia tra uomini, mentre con le macchine si tende storicamente a vederle come funzionali a specifici scopi. Alcuni ricercatori si chiedono se anche l’AI sia soggetta alla uncanny valley e se eventualmente l’abbia già superata. La nostra visione è che in relazione all’AI tutto stia avvenendo troppo velocemente e i casi d’uso più pervasivi sono incapsulati in algoritmi controllati, come ad esempio i contenuti suggeriti di Youtube o Spotify. Probabilmente in relazione all’AI la valle è sufficientemente arginata da sistemi di controllo che sono stati inseriti. Sarebbe certamente inquietante se una AI suggerisse di inserire cannabis in una ricetta di preparazione di un dolce, perché sarebbe potrebbe apparire autorevole ma allo stesso tempo folle.

Ciò che non perdoniamo ai sistemi automatici sono due cose: il loro potenziale in scalabilità (“se mi propone di mettere cannabis in una torta, chissà cosa potrebbe suggerire la prossima volta”) e la sensazione di incontrollabilità: se fosse una persona reale a fornire il suggerimento potrei fornirgli attuenuanti in relazione alle sue esperienze e convinzioni e, accedendo a queste, instaurare una comunicazione per farle cambiare idea. Tuttavia, se una AI fosse adeguatamente avanzata da darmi la sensazione di poter realmente entrare in una comunicazione, allora anche in questo caso potrei etichettare come “fattuale” e non “folle” la sua proposta.

La uncanny valley è un fenomeno basico della nostra mente, non è da confondersi con altre problematiche psicologiche di cui abbiamo accennato quali la dipendenza o altre forme di attaccamento all’AI.

(in copertina, installation view © estate of HR giger / © hajime sorayama photo by shigeru tanaka, courtesy of NANZUKA)

le puntate precedenti di queste riflessioni su coscienza, pensiero filolosofico e intelligenza artificiale le potete trovare qua:

Dio è nei dettagli? No, nei computer. Un’ipotesi sull’uomo, la Natura e l’Intelligenza Artificiale

Ockham ed Intelligenza Artificiale: rasoi per pelo e contropelo a confronto

Il Papa al G7 per parlare di AI, tra auspici, buone intenzioni e forse un poco di rassegnazione

Thomas Hobbes ed il deep learning. AI tra draghi ed algoritmi etici

Intelligenza artificiale, filosoficamente parlando (pt. 1)

76 domande cui non vorresti dover pensare. Tra cui fare l’amore con un robot

Essere o non essere, matematica o non matematica? Questo è il dilemma

Gombrowicz: arte, coscienza ed esistenza per la nostra immaturità