Abbiamo di recente scritto di come potrebbe inquadrarsi il significato di essere “uomo” in relazione alla AI (attraverso il pensiero di Giordano Bruno, Guglielmo da Ockham, Thomas Hobbes). Abbiamo sempre dovuto parlare della esistenza di Dio (inteso come metafisica, ciò che va oltre la fisica che conosciamo o che potremo mai conoscere razionalmente) non perché siamo affezionati a Dio ma perché senza una metafisica non ci sarebbe discussione: l’AI sarebbe un pezzo della natura. A onor del vero, un attento filosofo che includesse la fisica quantistica potrebbe obiettare che il principio di indeterminazione di Heisenberg potrebbe suggerire l’esistenza di un mondo ‘con una metafisica’, ma senza necessariamente includere un Dio.

Il principio di indeterminazione, postulato da Karl Heisenberg nel 1927 e che ha cambiato radicalmente tutto il sapere del genere umano fino a quel momento, enuclea che al livello subatomico le particelle non si “muovono” in modo deterministico (come, secondo la fisica classica, farebbe una pallina da tennis colpita da Jannik Sinner in un certo preciso punto) ma si muovono invece in modo probalistico, ogni particella può essere nello stesso istante in più posti ed avere una non determinata quantità di moto (che è la quantità di massa moltiplicata per la velocità della particella). Peggio: nel principio di indeterminazione si evince che non è possibile misurare simultaneamente la posizione e la quantità di moto di una particella senza alterare l’una o l’altra, dato che l’atto di misurazione cambia definitivamente il sistema (come quando chiedete al vostro partner di andare in vacanza da soli, una volta chiesto… il rapporto si altera, a prescindere da ciò che farete davvero). Ora, per questo principio, e solo per questo principio, i materialisti potrebbero accettare il concetto di libero arbitrio. Infatti se restiamo nella fisica classica (dove si sa perfettamente dove finiranno le palline da tennis una volta colpite) non ci sarebbe libero arbitrio. Il big bang più le leggi chimiche e le leggi fisiche determinerebbero al 100% tutto il nostro futuro, non ci sarebbe uomo diverso dalla natura (come dicevano Giordano Bruno e Baruch Spinoza), non ci sarebbe eccedenza rispetto ad una storia già scritta.

Quindi, è proprio grazie al principio di indeterminazione che potremmo ipotizzare una realtà in cui Dio non esiste e, allo stesso tempo, esiste una forma di libero arbitrio. Bene, parcheggiando per un attimo questa critica, alla quale rispondiamo artificiosamente, e senza pretesa di dire una cosa giusta, che in fin dei conti la fisica quantistica è sempre una fisica, restiamo, in questo articolo, nel dualismo: o Dio esiste e quindi ci chiediamo filosoficamente che ruolo abbia l’AI rispetto all’uomo, oppure Dio non esiste e quindi la domanda perde il carico filosofico, mantenendo certamente il carico economico, sociale ed etico.

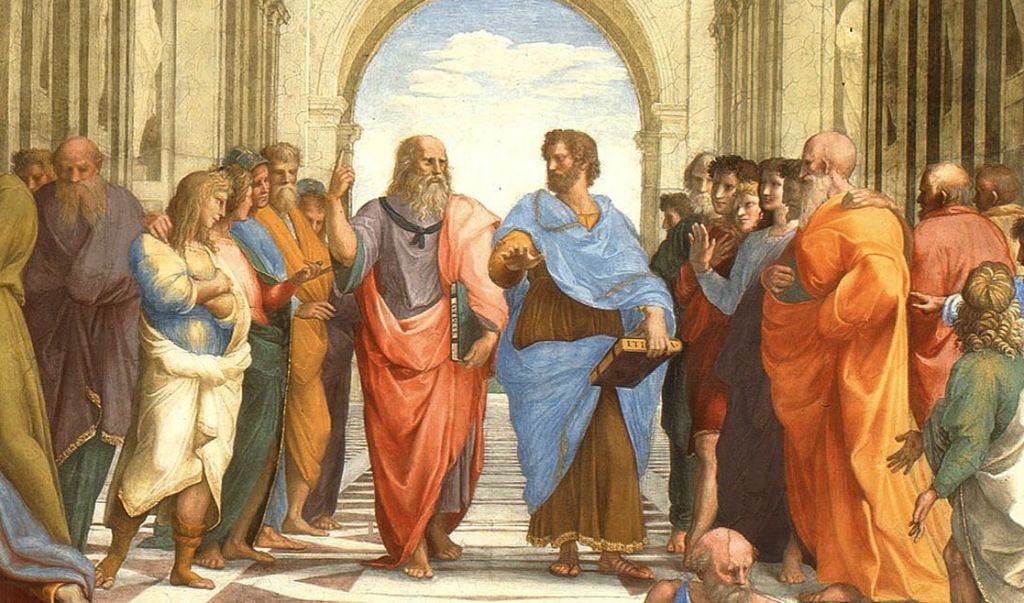

Il primo a domandarsi sull’intelligenza artificiale è Platone. Ma prima chiariamo un punto: informatica non significa “computer”, ma invece significa “manipolazione della informazione”. Esiste informatica anche senza computer e addirittura senza energia elettrica. Informatica è informazione computabile. Ogni volta che una sequenza finita di calcoli è formale, eseguibile in modo ripetibile, dal risultato effettivo, determinabile ed arriva al risultato in un tempo finito… allora siamo di fronte ad informatica.

Ok ok… qualcuno potrebbe obiettare che la fisica quantistica ci apre ai computer quantistici, che violerebbero parte di quello che ho appena scritto, ma andiamo avanti, ancora non sono in commercio per i comuni mortali! Quindi dicevo, Platone circa nel 450 a.C. nel testo Eutifrone, riporta che fu Socrate a chiedere all’amico Eutifrone come si possa definire essere pio o empio in modo formale e universale. La questione era che entrambi erano in coda dall’Arconte per la giustizia, Socrate accusato di depistare i giovani portandoli verso ideologie e divinità non convenzionali, Eutrifrone in coda per denunciare il padre di omicidio (poiché aveva lasciato morire di stenti un dipendente che a sua volta aveva, da ubriaco, ucciso uno schiavo). Socrate pensa che Eutrifrone debba essere davvero pio per accusare il padre, così gli chiede un sistema certo per capire quando si è certamente pii: “Quali esattamente sono le caratteristiche che rendano l’agire pio, in modo da usarle come standard quando giudico altri uomini?”.

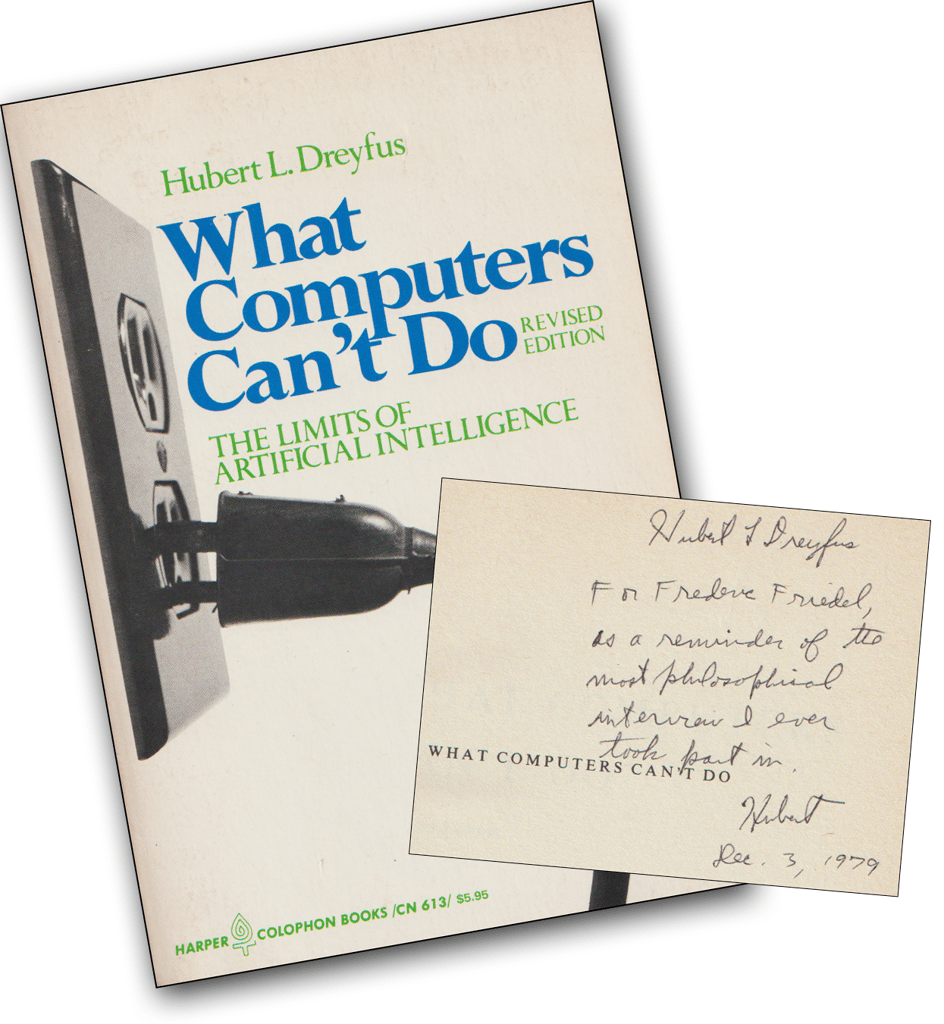

Socrate sta chiedendo all’amico ciò che i teorici dell’informatica chiamano “una procedura eseguibile”. Per Platone ogni conoscenza dovrebbe essere rappresentata da specifiche eseguibili: come ci fa notare Hubert Dreyfus in What computers can’t still do – A Critique of Artificial reason (1972), se in “know-how” il “know” non diventa “how” non siamo in presenza di conoscenza, ma piuttosto di un “credo”. Platone tuttavia riesce in parte a smentirsi, come Cartesio del resto, dal momento che entrambi non riescono ad abbandonare il concetto di “intuito”, il primo, ed il concetto di “coscienza”, il secondo.

Bisogna arrivare ad Hobbes per fare a meno di ogni eccedenza rispetto alla materia e stabilire che tutto è computabile. Per Hobbes quando un uomo “ragiona”, sta elaborando logicamente elementi formali. Il culmine che porta poi ad una completa teoria dell’informazione (l’informatica) arriva con l’invenzione del sistema binario (0 e 1, grazie al matematico Leibiniz nel 1703 in Explication de l’Arithmétique Binaire) ed alla logica booleana di George Boole che seguendo le orme di Thomas Hobbes ritenne che il modo di ragionare dell’uomo potesse essere formalizzato e quindi “inventò” un’algebra della logica (piccolo gossip, Boole era sposato con la figlia di sir George Everest, che diede il nome all’omonimo monte).

La logica booleana prevede: Vero AND Falso = Falso / Vero OR Falso = Vero / Vero AND/OR Vero = Vero / Falso AND/OR Falso = Falso / NOT vero = falso / NOT falso = vero

a cui aggiungiamo per chiarezza:

SE Vero ALLORA Vero / SE FALSO ALLORA “vale qualunque cosa”.

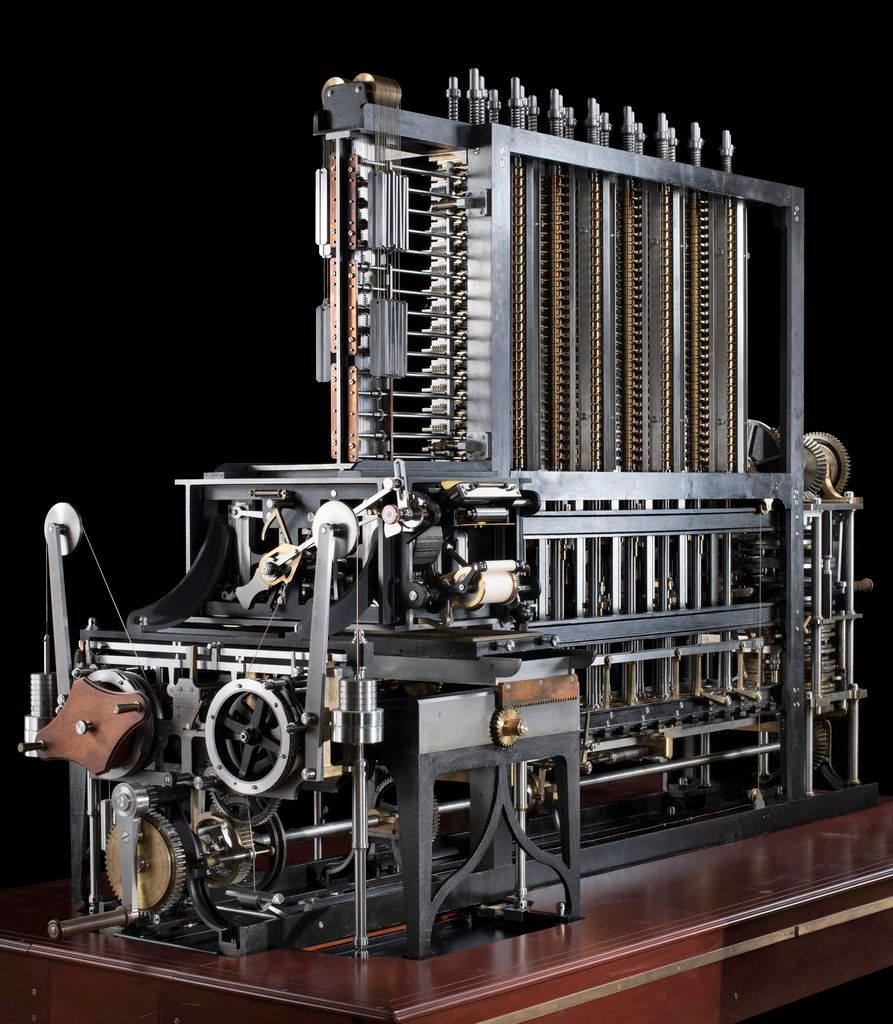

L’ultimo passo verso la computazione, e quindi verso la possibilità di vedere l’intelligenza artificiale procedere in modo apparentemente autonomo e con una adeguata velocità, arriva con la ideazione del primo computer per mano di Charles Babbage (1835), che sebbene fosse meccanico invero replicava il funzionamento di un moderno computer digitale (grazie a schede perforate e funzioni logiche e matematiche “cablate” per mezzo di ingranaggi -tipo un complicato orologio).

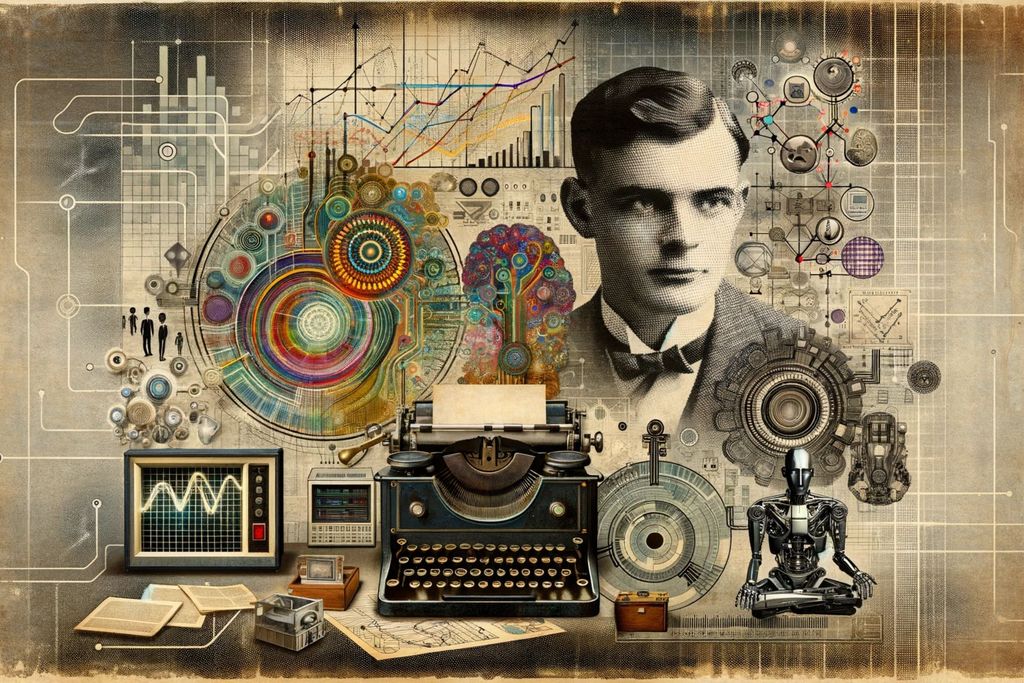

Un computer analogico procede per cambiamento di misure fisiche (come volume di liquido o tensioni elettriche), mentre un computer digitale procede su una base meramente formale codificata con segnali binari (BIT). Quello di Babbage era un computer meccanico dalla potenza formale di uno digitale, quindi programmabile, ma costruibile senza componenti elettriche. Molto prima degli scritti di Dreyfus del 1972, è doveroso citare che nel 1950, sulla rivista Mind, Alan Turing scrisse un articolo dal titolo “Computing machinery and intelligence” in cui descriveva quello che sarebbe divenuto noto come il test di Turing: su questo articolo si basano praticamente tutti i successivi sull’intelligenza artificiale.

Da questa prima dissertazione storica possiamo comprendere quindi che “intelligenza artificiale” è qualcosa che va definito in seno a ciò che è computabile formalmente, ma nello stesso tempo la definizione richiede delle prove di reale intelligenza. Ad oggi i livelli di intelligenza dei sistemi automatici sono stati schematizzati in vari livelli, che riassumiamo così:

Narrow AI, quando il computer è i grado di fare meglio dell’uomo su specifici task (come giocare a scacchi)

Generative AI, quella che abbiamo oggi, dove è in grado di scrivere testi, creare riassunti, identificare un sentimento

General AI, quando l’AI sarà in grado di risolvere problemi al livello di un essere umano

Super AI, quando l’AI saprà porsi problemi e risolverli anche dove gli essere umani non arrivano

A questa lista andrebbe aggiunta la Artificial Life (Alife) dove il tema etico e ontologico ci costringe a definire cosa sia la vita, l’Alife è l’ultima frontiera per i ricercatori in quanto l’AI non è più solo un oracolo in gentile attesa di essere usata, ma fa parte di un essere vivente, totalmente digitale (ma sul totalmente stiamo a vedere).

Nel periodo che intercorrerà tra General AI e Super AI (detta anche strong AI), secondo Makoto Kureha, professore di etica alla Waseda University (in Implications of Automating Science, 2023), l’AI sarà in grado di generare documenti scientifici, il compito degli scienziati sarà quello di capire e “tradurre” i risultati di tali ricerche affinché siano comprensibili ed applicabili.

Un’idea, un sogno

Cosa ci ha portati dal Babbage, o addirittura da Platone ad oggi? Il nostro esempio di Platone possiamo considerarlo AI solo a posteriori e a livello didattico, ancora negli anni Settanta, con ormai super computer disponibili la comunità degli scienziati aveva tanti sogni, ma risultati decisamente scarsi e scoraggianti, eppur tuttavia sono andati avanti imperterriti, certi che il risultato sarebbe arrivato.

È sempre Hubert Dreyfus nel ’72 a scrivere: “In spite of grave difficulties, workers in Cognitive Simulation and Artificial Intelligence are not discouraged. In fact, they are unqualifiedly optimistic” (Nonostante le gravi difficoltà, i lavoratori della simulazione cognitiva e dell’intelligenza artificiale non si scoraggiano. Anzi, sono ottimisti senza riserve). Alla base del loro “inqualificabile ottimismo” c’è un assunto di base principale: il modo di ragionare dell’uomo procede in modo discreto, potremmo dire temporizzato, esattamente come quello dei computer. Se la natura con questo metodo ha prodotto l’intelligenza umana, la scienza con lo stesso metodo potrà produrre intelligenza artificiale altrettanto valida. È interessante a questo punto riepilogare le assunzioni di questi scienziati in quegli anni sottostanti la loro ricerca, esse sono:

L’assunzione biologica. Come detto il cervello umano procede in modo temporizzato ed i connettori neuronali possono comunicare con segnali formalizzabili in acceso/spento.

L’assunzione psicologica (o filosofica). L’empirismo di David Hume è basato sul fatto che tutta la conoscenza nella mente dell’uomo arriva per via delle impressioni, che possiamo paragonare alla informazione memorizzata nei BIT. Di contro è l’idealismo di Kant che con le sue categorie dell’intelletto (tra cui potremmo inserire anche la logica booleana) suggerisce come anche il cervello umano abbia il suo “software di base”. Hume e Kant sono la base per fornire un modello agli informatici, la strada era spianata. Ritorneremo su questo interessantissimo punto presto.

L’assunzione epistemologica. L’intelligenza dell’uomo è rappresentabile in modo formale, quindi eseguibile da un automa, come un computer. Ciò non implica che l’uomo ragioni come un computer, ma che il suo ragionare è formalizzabile. Per far comprendere: grazie alle equazioni differenziali possiamo modellare il moto dei pianeti, nonostante che i pianeti non “sappiano” nulla di equazioni differenziali.

L’assunzione ontologica. Tutta la conoscenza deve poter essere espressa in BIT, quindi deve essere discreta (enumerabile), esplicita e determinata. Come abbiamo detto sopra fino a questo punto l’ipotesi di indeterminazione non è presa in considerazione: tutto deve essere rappresentabile in modo chiaro. Tale ipotesi ci suggerisce che quando si ha a che fare con l’intelligenza il tutto deve essere assemblato dalle parti, non vi è spazio per una conoscenza non intellegibile.

Queste assunzioni furono poste nel lontanissimo 1972, certamente in un momento molto distante da quello di oggi, ma loro formulazione, come altre di cui parleremo, sono un passaggio fondamentale nell’ambito dello sviluppo dell’AI.

le puntate precedenti di queste riflessioni su coscienza, pensiero filolosofico e intelligenza artificiale le potete trovare qua:

Dio è nei dettagli? No, nei computer. Un’ipotesi sull’uomo, la Natura e l’Intelligenza Artificiale

Ockham ed Intelligenza Artificiale: rasoi per pelo e contropelo a confronto

Il Papa al G7 per parlare di AI, tra auspici, buone intenzioni e forse un poco di rassegnazione

Thomas Hobbes ed il deep learning. AI tra draghi ed algoritmi etici