Siamo sinceri, chi non ha un po’ di astio per la matematica alzi la mano. Sterile, troppo semplice, così distante dalla nostra innata (innata?) necessità di sentirci umani ed emozionabili. Tuttavia chi di noi non vuole vivere meglio, o almeno “vivere”? La matematica è stata uno strumento fondamentale perché la fisica progredisse, è incredibile come le sue strutture formali e semplici abbiano permesso alla fisica di modellare e addirittura predire la realtà che ci circonda. Questa trovata teorica, la matematica, sta modellando l’Intelligenza Artificiale e in alcuni laboratori sta anche aprendo la strada alla vita artificiale (A-life). Se è vero che essa è connessa alla nostra vita reale molto più di quanto vorremmo, grazie ad alcuni studiosi è entrata anche nel mondo delle scienze sociali, attraverso una disciplina chiamata “Teoria dei Giochi“.

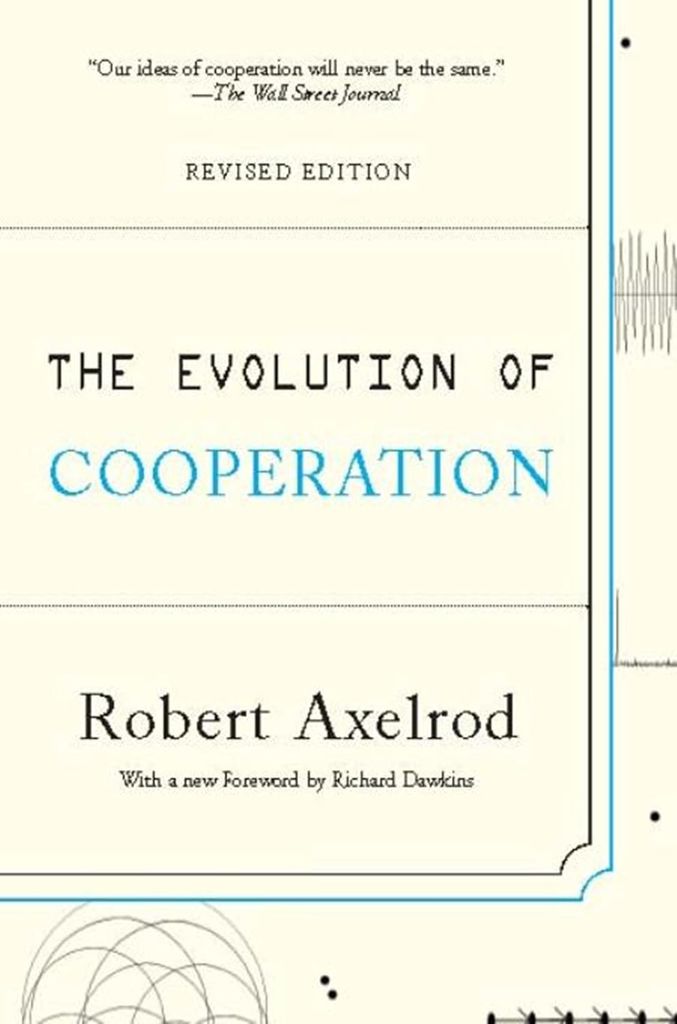

Come informatico incontrai tale disciplina nei primi anni Novanta attraverso un libro che invero cambiò il corso della mia vita e che di recente sono andato a recuperare (non ricordandomi il titolo né l’autore mi sono limitato a indicare a ChatGPT di cosa parlasse e lui prontamente lo ha recuperato). Parlo del testo The Evolution of Cooperation di Robert Axelrod che nella versione rivisitata ha una prefazione, niente meno che di Richard Dawkins, di cui mi sono dovuto trattenere di parlarne quando ho accennato alla teoria della evoluzione in un precedente articolo (Il darvinismo universale nell’era della AI) e sui cui inevitabilmente vorrò tornare.

Di cosa parla The Evolution of Cooperation? Il ricercatore-autore si pone una semplice questione: sotto quali condizioni un agente inserito in un contesto sociale, assente di un governo centrale, dovrebbe cooperare o defezionare? L’autore cita Thomas Hobbes e della natura “egoista” dell’uomo, anche noi ne abbiamo parlato in un precedente articolo (Thomas Hobbes ed il deep learning. AI tra draghi ed algoritmi etici).

Non sempre è possibile avere un governo autoritario o una legge sovrana (il Leviatano), si pensi ad esempio agli stati internazionali. È stato quindi creato un gioco per simulare il contesto e trovare una risposta. Il ricercatore ha invitato 20 esperti, tra sociologi, informatici e matematici, chiedendo loro di programmare un agente che potesse giocare in coppia a turno contro tutti. La singola partita consisteva in 30 mosse che i due contendenti avrebbero dovuto fare in una sorta di pari e dispari, che nel caso specifico erano “Coopero” o “Defeziono“. In pratica uno contro l’altro, assieme, per 30 volte devono lanciare una delle due opzioni. Se entrambi cooperano ottengono 3 punti ciascuno, se entrambi defezionano ottengono un solo punto ciascuno, se uno defeziona e l’altro coopera, chi defeziona ottiene 5 punti e l’altro (che rimane evidentemente fregato), zero. In pratica ad un singola mossa, senza sapere cosa farà l’altro, converrebbe sempre defezionare, tuttavia se tutti cooperassero il sistema sarebbe ottimizzato, visto che verrebbero erogati ben 6 punti in totale contro 5 o 2.

Al torneo si presentarono 20 algoritmi ben agguerriti, sorprendentemente, tuttavia, vinse un algoritmo di sole due istruzioni: alla prima mossa coopera, dalla seconda mossa fino all’ultima fai quello che il tuo avversario ha fatto alla mossa precedente. In pratica “occhio per occhio, dente per dente”, chiamato in inglese “Tit for Tat“.

Si noti che tecnicamente Tit for Tat all’ultima mossa avrebbe potuto applicare il ragionamento che essendo l’ultima avrebbe potuto defezionare ad ogni modo, massimizzando il risultato (come quelli che all’ultimo giorno di soggiorno rubano l’accappatoio in hotel, qualcuno mi disse nella mia crescita educativa “l’occasione fa l’uomo ladro”, ma io, oggi da adulto rispondo “No, l’occasione fa il ladro per quello che era, un ladro!”). Tit for Tat non sceglie di defezionare nell’ultima mossa ma rimane fedele alla sua strategia, se infatti applicasse questo ragionamento da “vigliacco”, dovrebbe applicarlo anche alla penultima, visto che ragionevolmente anche l’avversario dovrebbe fare lo stesso ragionamento… il che porterebbe, andando a ritroso, a una defezione continua.

Il ricercatore non contento mostrò l’algoritmo vincente alla comunità scientifica e chiese di paretecipare a un secondo torneo. Ora che si conosceva il vincitore, chiese di fornire algoritmi migliori, ampliò anche il numero dei giocatori. Sorprendentemente vinse ancora Tit for Tat. La matematica ci insegna che cooperare, ma anche punire quando è necessario, sia il modo migliore per dominare.

È interessante estendere il gioco allo studio delle classi sociali. L’esercizio consiste nell’assegnare un’etichetta ai giocatori; ipotizziamo le etichette “benestante” e “ghetto“. Supponiamo che i due gruppi tendano a defezionare maggiormente quando giocano contro l’altro gruppo. Ciò porta a due conseguenze: la prima è ovvia, ovvero che il sistema non è ottimizzato, se tutti collaborassero sarebbe nel complesso meglio; la seconda è che se uno dei due gruppi è inferiore numericamente sarebbe punito nel complesso, infatti si confronterebbe nella media con molti più agenti del gruppo nemico e nella defezione raccoglierebbe mediamente meno punti. In pratica le lotte sociali tendono a sfavorire chi è numericamente inferiore, a parità di potere coercitivo.

Come si sposa questa strategia “Occhio per Occhio” rispetto all’invito di testi spirituali che invece invitano a cooperare sempre, indipendentemente dalle situazioni avverse? Come interpretare la Bibbia nel passo del vangelo di Matteo (18: 21-22)?

Allora Pietro gli si avvicinò e gli disse: “Signore, quante volte dovrò perdonare al mio fratello, se pecca contro di me? Fino a sette volte?”.

E Gesù gli rispose: “Non ti dico fino a sette, ma fino a settanta volte sette”.

Intanto notiamo come anche Gesù ponga un limite. A onor del vero, Tit for Tat in alcuni tornei successivi è stato battuto da Tit for Two Tats, ovvero defeziono se tu nelle due precedenti mosse hai defezionato. Tit for two tats tollera di più, è più paziente. Gesù propone Tit for 490 Tats, che indubbiamente nel torneo sarebbe perdente, visto che ci sono solo 30 mosse in ogni partita. La tradizione giudaica proponeva, prima di Gesù, di perdonare fino a tre volte.

Perdonare ad oltranza è una scelta perdente? Penso che la teoria dei giochi ci indichi come in un orizzonte temporale breve la risposta sia affermativa, nel caso limite di una sola mossa converrebbe sempre defezionare, mentre perdonare 490 volte sarebbe perdente anche su un torneo di 30 colpi. Ma come interpretare la domanda in un orizzonte molto lungo, suggerito da una vita, o dalla sopravvivenza di una specie, oppure ancora in un orizzonte dell’eternità?

Io personalmente fornisco una interpretazione diversa, direi gnostica. Io non penso che Gesù si riferisse a un contesto di eternità e del resto neppure ritengo necessario che si debba accedere al concetto di Dio per giustificare questa posizione apparentemente esagerata e perdente. Perdonare 490 volte, settanta volte sette, ha due significati: uno funzionale per la comunità e l’altro personale. Il primo è chiaro: perdonando otre il normale fornisco un esempio, divento un eroe, qualcosa da imitare; possibilmente sacrifico un aspetto di me, ma con lo scopo di aiutare gli altri a riflettere. Il secondo significato mi sovviene da un libro che potete trovare nelle librerie esoteriche e che si chiama Un corso in Miracoli, ove uno dei più importanti insegnamenti è che il miglior modo di perdonare è: sapere che non vi è nulla da perdonare. Tale insegnamento è alla base di una famosa frase del Dalai Lama: chi ti fa soffrire, prendilo come maestro. Nel perdonare qualcuno, invero gli stai ricordando l’errore. La teoria dei giochi esposta da Axelrod è limitata ad un sistema statico, la realtà degli esseri viventi, ed in divenire anche di quelli digitali, è che l’agente cambia se stesso. Osservando il comportamento di altri ogni agente può migliorare se stesso a tal punto da accettare un piccolo svantaggio nel breve per un bene più ampio. Inoltre nell’insegnamento spirituale vi è insito il livello della qualità della vita desiderata. Una vita può essere condotta per massimizzare un valore materiale, come soldi, beni, oppure per massimizzare un potere intellettuale o spirituale. Cooperare anche a fronte di defezioni fornisce un enorme potere intellettuale. In sistemi complessi come la nostra esistenza, una auto consapevolezza superiore, che deriva dal potere di “poter perdonare”, viene percepita come leadership. Le attuali intelligenze artificiali sono state programmate con questo concetto, paradossalmente sono più “calme” di noi. Prima di rispondere a un collega o a un fornitore, passate la vostra email nella AI e e chiedete come può essere migliorata per trarre dall’altra persona il suo miglior potenziale, dalla risposta si evince una capacità di leadership dell’AI enormemente superiore alla nostra. Invero l’AI non ha un ego e non ha paura di perdere la stima in se stessa, quindi ragiona solo in termini di ottimizzazione. Uno dei primi insegnamenti di “Un corso in miracoli” è “nulla di ciò che vedo ha alcun significato”, è proprio quello che fa la AI; per essa, nulla ha significato. Se qualcosa non ha significato posso perdonare, nel perdonare accetto di vedermi come distaccato, nel vedermi come distaccato posso scegliere cosa davvero è importante per me e gli altri possono prendermi come esempio.

Negli ultimi tre mesi abbiamo approfondito la relazione tra posizioni filosofiche, e in particolare etiche, nei confronti dell’AI. Sarà interessante prossimamente sviluppare un ragionamento in relazione alle posizioni gnostiche e spirituali. Ci piace terminare possibilmente con una domanda: La fredda matematica dell’AI potrà suggerirci insegnamenti spirituali?

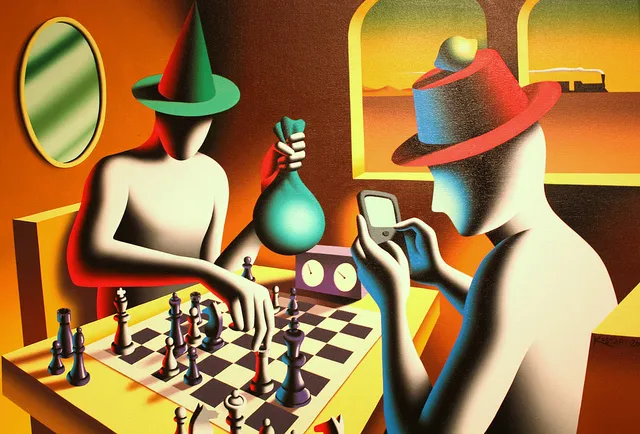

In copertina: Mark Kostabi, Marcel Duchamp en passant Mark Kostabi (Swindle of the Century), 2002.

le puntate precedenti di queste riflessioni su coscienza, pensiero filolosofico e intelligenza artificiale le potete trovare qua:

Dio è nei dettagli? No, nei computer. Un’ipotesi sull’uomo, la Natura e l’Intelligenza Artificiale

Ockham ed Intelligenza Artificiale: rasoi per pelo e contropelo a confronto

Il Papa al G7 per parlare di AI, tra auspici, buone intenzioni e forse un poco di rassegnazione

Thomas Hobbes ed il deep learning. AI tra draghi ed algoritmi etici

Intelligenza artificiale, filosoficamente parlando (pt. 1)

76 domande cui non vorresti dover pensare. Tra cui fare l’amore con un robot

Essere o non essere, matematica o non matematica? Questo è il dilemma

Gombrowicz: arte, coscienza ed esistenza per la nostra immaturità

Paura e desiderio ai tempi dell’AI